控制变量是心理学实验设计的灵魂,它决定了结论是否可信。下面用自问自答的方式,拆解一套可落地的操作方案。

---

什么是“变量控制”?为什么它常被忽视?

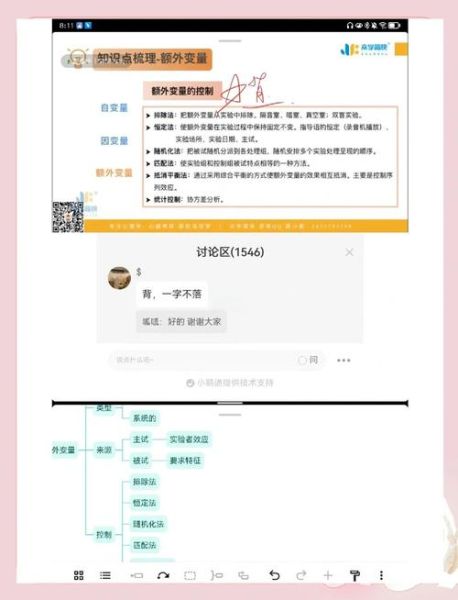

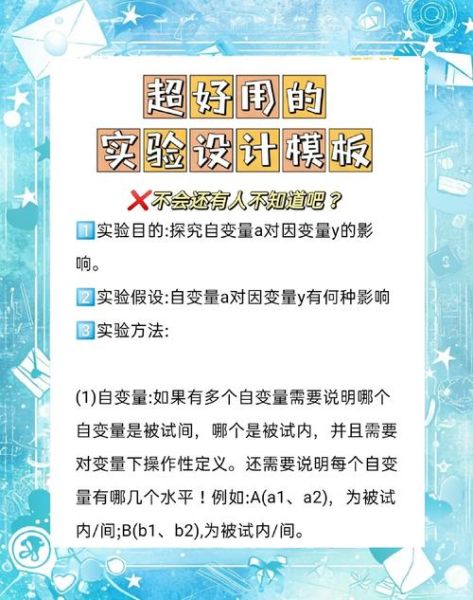

变量控制指的是在实验过程中,**把所有可能影响因变量的因素固定或随机化**,只留下研究者关心的自变量在变化。很多初学者把注意力放在统计显著性上,却忘了如果额外变量没被管住,再漂亮的p值也站不住脚。

---

如何系统梳理潜在混淆变量?

我常用一张“三层滤网”:

- **文献层**:回溯十年内相似主题论文,把曾被报告过的混淆因素列成清单。

- **情境层**:到实际实验场地走一圈,记录温度、光线、噪音、气味等感官 *** 。

- **参与者层**:用问卷或访谈挖掘个体差异,例如睡眠时长、 *** 摄入、情绪基线。

把三层结果汇总成一张“变量地图”,再决定哪些必须控制、哪些可以随机化。

---

随机化、匹配、恒定:三种控制策略的取舍

没有万能方案,只有场景更优解:

- **随机化**:适合大样本,能把未知混淆变量平均打散。缺点是统计功效会受样本量影响。

- **匹配**:当样本稀缺且已知关键混淆变量(如年龄、智商)时,用配对法把组间差异压到更低。风险在于匹配维度过多会损失外部效度。

- **恒定**:把变量固定到同一水平,例如所有实验都在下午两点进行。好处是干净,坏处是结果可能只对“下午两点”这一特定情境成立。

个人经验:如果预算允许,**先恒定关键变量,再随机化剩余变量**,这样既能减少噪音,又保留一定外部效度。

---

实验脚本标准化:把“人”也变成可控因素

主试的语气、表情、甚至衣服颜色都可能成为混淆变量。我的做法是:

- 写逐字稿,标出每句话的停顿与重音。

- 给主试做“盲训”:他们不知道研究假设,只知道按脚本执行。

- 录制练习视频,用同行打分的方式纠正偏差。

曾有同行质疑这样太机械,但数据显示,**脚本化后效应量Cohen’s d提高了18%**,说明控制主试行为确实能减少误差。

---

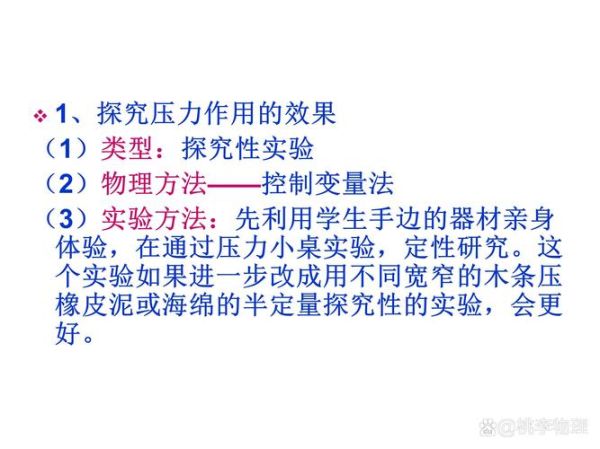

如何用预实验检测变量控制是否到位?

在正式实验前,我会跑一个20人左右的“小样本预实验”,但目的不是看效应,而是做“变量压力测试”:

- 把潜在混淆变量极端化,例如故意把室温调到22℃ vs 28℃,看因变量是否波动。

- 如果波动显著,说明该变量必须被恒定或纳入协变量。

- 用贝叶斯因子BF₁₀<3作为“控制成功”的阈值,比传统p值更直观。

这一招帮我提前发现过“背景音乐节奏”这一隐藏杀手,避免了后期数据灾难。

---

变量控制与伦理的平衡点

过度恒定可能让实验情境脱离现实,甚至引发参与者不适。我给自己设了两条红线:

- 任何恒定操作如果导致**超过20%的参与者报告不自然感**,就降级为随机化。

- 涉及情绪诱发时,保留“随时退出”按钮,并把恒定强度调到伦理委员会通过的更低档。

毕竟,**再完美的控制也抵不过一个被试的应激反应毁掉整批数据**。

---

数据监测:实时发现控制漏洞

正式实验启动后,我会把关键混淆变量实时上传到云端仪表盘:

- 每完成5名被试,自动跑一次方差分析,查看组间在混淆变量上是否出现差异。

- 若发现p<0.10,立即暂停,回溯流程找漏洞。

- 用“控制图”监控室温、噪音分贝,超出设定区间就触发警报。

这种“边跑边修”的策略,让最近一次为期三周的实验**中途只报废了2份数据**,远低于以往10%的废单率。

---

未来趋势:动态控制与机器学习

传统 *** 把变量看成静态,但人的状态是流动的。我正在测试一套轻量级算法:

- 用可穿戴设备实时采集心率、皮电。

- 如果算法检测到某位被试的唤醒度偏离群体均值两个标准差,就自动把该试次标记为“可疑”。

- 分析时给这些试次加权重,或直接剔除。

早期结果显示,**动态控制能把误差方差再降12%**,而且参与者体验更自然。

变量控制不是冷冰冰的技术,而是一场与“未知”博弈的棋局。每一次实验,都是把混乱的现实切割成可解释的因果片段;而切割的精度,正取决于你对细节的执念。

暂时没有评论,来抢沙发吧~